Trainings am VSC - Simeon Harrison

Supercomputing und KI hautnah: Trainings für jedes Level am Vienna Scientific Cluster

Hochleistungsrechnen und Künstliche Intelligenz bieten riesige Chancen für große und kleine Unternehmen. Aber wie gelingt der Start – und wie geht’s danach weiter? Dank des EU-Projekts EuroCC ist es jetzt besonders einfach und kostengünstig, Trainings in Supercomputing und KI zu erhalten, erzählt Simeon Harrison, Trainer an Österreichs High-Performance Computer, dem Vienna Scientific Cluster.

Das Interview führte Bettina Benesch

Simeon, ihr bietet am Vienna Scientific Cluster (VSC) verschiedene Trainings und Webinare an. An wen richtet sich euer Angebot?

Wir sind für alle Personen da, die sich dem Thema High-Performance Computing (HPC) und Künstliche Intelligenz (KI) annähern oder ihr Wissen vertiefen möchten – und zwar ganz unabhängig vom Niveau: Wir veranstalten Trainings für Anfänger:innen und Fortgeschrittene und haben auch im Intermediate-Bereich Angebote, die wir noch weiter ausbauen werden.

Habt ihr vor, das Angebot auch thematisch zu erweitern?

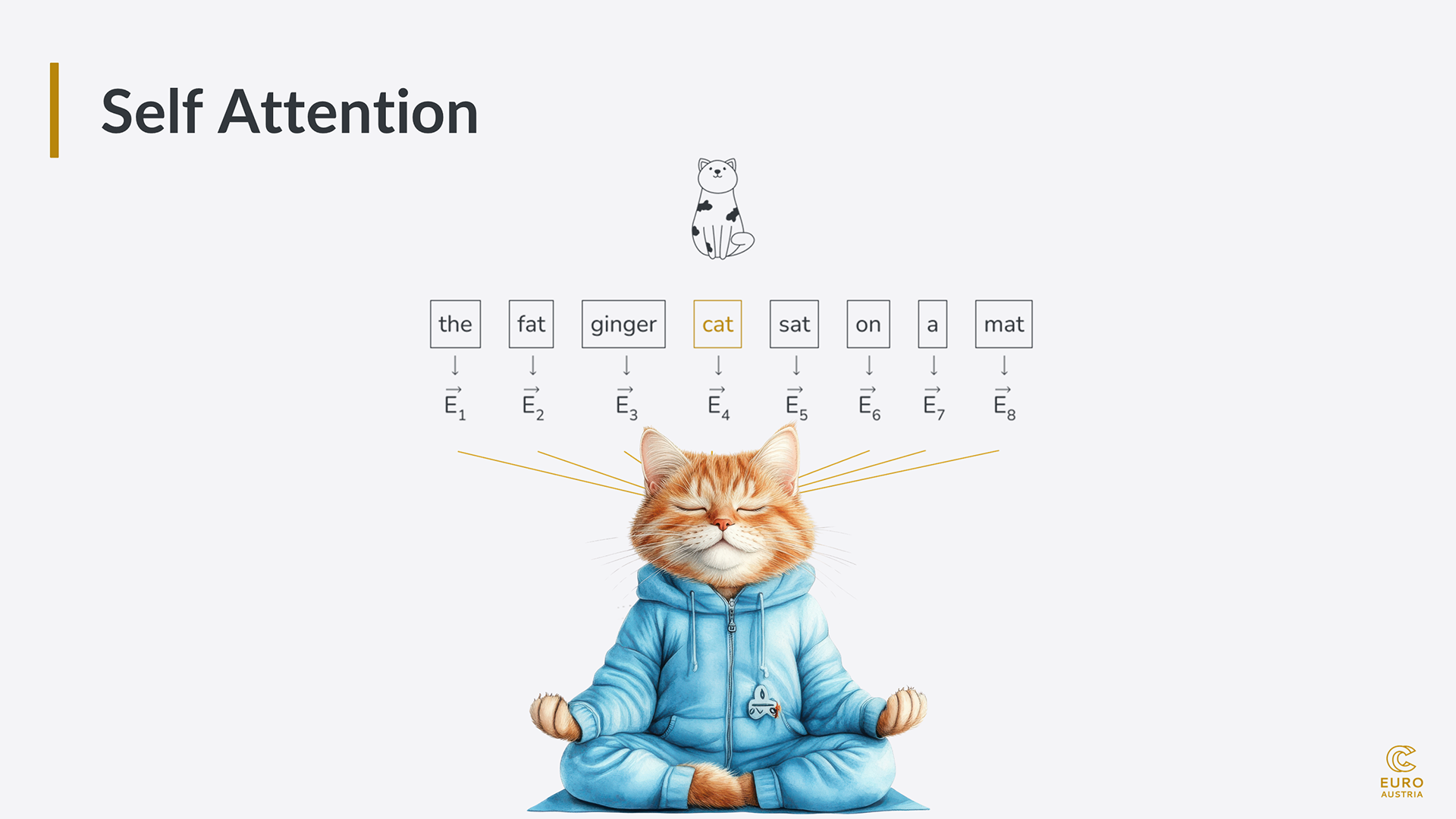

Zum Thema Deep Learning haben wir neue Kurse geplant. Da entsteht gerade eine Kooperation mit Polen, der Slowakei, Tschechien und Slowenien. Generell wird uns das Thema Artificial Intelligence (AI) viel mehr beschäftigen und wir werden da sowohl in die Breite als auch in die Tiefe gehen.

Woher kommen die Trainer:innen eurer Kurse?

Claudia Blaas-Schenner hat das Kursangebot am Vienna Scientific Cluster im Jahr 2015 initiiert und leitet seither die Trainings. Sie beschäftigt sich seit 30 Jahren mit HPC und ist auch verantwortlich für alle Kurse, die über das EU-Projekt EuroCC laufen. Claudia ist Expertin für Message Passing Interface (MPI) und hält auch alle Kurse dazu (MPI = ein Standard für Nachrichtenaustausch bei parallelen Berechnungen auf verteilten Rechensystemen).

“

Wir sind mit unseren Kursen für alle da, die sich Supercomputing und KI annähern oder ihr Wissen vertiefen möchten.

„

Ich unterstütze sie und halte auch eigene Trainings, wie zum Beispiel den Einsteigerkurs Linux Command Line, die Intermediatekurse Python for HPC, Introduction to Deep Learning oder Large Language Models on Supercomputers. Zusätzlich sind andere Kolleg:innen im Team, etwa bei Trainings zur GPU- oder C++-Programmierung. Auch beim Introduction-Kurs für alle neuen VSC-User:innen haben wir weitere Trainer:innen dabei, um das Angebot abwechslungsreicher zu machen und auch auf sehr spezifische Fragen eingehen zu können.

Was kosten eure Trainings?

Im Rahmen von EuroCC sind unsere Trainings kostenlos für Personen, die an Universitäten oder in Unternehmen in den teilnehmenden europäischen Ländern arbeiten. Es gibt am VSC weitere Kurse, die nicht ins Programm von EuroCC fallen; die sind teilweise kostenpflichtig für Kund:innen aus der Wirtschaft; das betrifft zum Beispiel den C++-Kurs. Aber selbst wenn Kurskosten anfallen, sind diese sehr moderat.

Wo steht denn Österreich im Bereich HPC-Training?

Ob man es glaubt oder nicht, aber Österreich ist ganz vorne mit dabei, was das Trainingsangebot betrifft. Wir sind eines der großen Trainingszentren in Europa.

Wenn du an Forscher:innen oder Unternehmen denkst, die in HPC einsteigen: Was sind die größten Herausforderungen, vor denen sie stehen?

Die erste große Hürde für Personen, die bis dato nichts mit HPC zu tun gehabt haben, ist, dass die Maschinen linuxbasiert sind. Das heißt. Man muss sich erst mit Linux auseinandersetzen. Das zeigen wir in unseren Kursen. Wenn man das einmal draufhat, ist der Rest relativ einfach. Wir bieten für alle User:innen unseres Supercomputers auch einen Linux-Kurs an, um diese Herausforderung zu meistern. Wenn die erste Hürde genommen ist, ist es eine sehr effiziente und schnelle Art, um zum Ziel zu gelangen.

“

Befasse dich genau mit deinem Code und achte darauf, dass er lokal auf deinem Computer gut läuft. Da lässt sich schon viel an Performance herausholen.

„

Was sind deine Tipps für Menschen, die gerade mit HPC starten oder starten möchten?

Wer die Basics der Linux-Command-Line kennt, ist schon mal gut unterwegs. Ein weiterer Tipp ist: Befasse dich genau mit deinem Code und achte darauf, dass er lokal auf deinem Computer gut läuft. Da lässt sich schon viel an Performance herausholen.

Außerdem ist es wichtig, sich mit dem Thema Benchmarking/Profiling auseinanderzusetzen. Da geht es darum, Metriken zu erfassen: Welche Code-Abschnitte brauchen wie viel Zeit, wo sind die Flaschenhälse, wo dauert etwas ganz besonders lange, welche Hardware-Ressourcen brauche ich? Wenn man sich damit beschäftigt, bekommt man schon eine Ahnung, was man rausholen kann oder was machbar ist mit HPC.

So entsteht auch ein Gefühl dafür, wie viele Ressourcen am Supercomputer notwendig sind. Denn wer zu wenig Speicher anfordert oder zu wenig Zeit einplant, riskiert das berühmte OOM: Out of Memory oder das ebenso häufige Job Timeout. Dann heißt es: zurück zum Start.

Wie bildest du dich selbst weiter?

Ich bin da sehr oldschool: Ich liebe Bücher. Ich google auch und benutze verschiedene Foren, aber das Grundverständnis hole ich mir tatsächlich am liebsten aus Büchern. Wobei die Entwicklung natürlich so schnelllebig ist, dass der Buchdruck oder auch ein E-Book oft nicht hinterherkommt. Dann hilft es mir, wenn ich auf diversen Plattformen unterwegs bin.

Hugging Face ist zurzeit ganz groß im KI-Bereich, der Hardware-Hersteller Nvidia bietet einiges an, und es gibt andere Ressourcen wie TensorFlow Hub oder PyTorch Hub. Auch bei Papers with Code finde ich immer wieder Publikationen und den dazugehörigen Code. Auf Towards Data Science werden Artikel und Erklärungen zu diversen Themen veröffentlicht, und auf YouTube habe ich auch den einen oder anderen bekannten Namen abonniert. Das alles zusammen hält einen halbwegs fit.

Was ich an dieser Stelle auch betonen muss: Es hilft nicht, wenn man 100 Bücher liest oder die Beiträge der Hugging Face Webseite auswendig lernt. Man muss das Gelernte selbst ausprobieren, damit man vor allem durchs Scheitern lernt. Mein Motto dazu: „If in doubt, code it out!“, sprich Probieren geht über Studieren. Es ist natürlich hilfreich, wenn man an einem konkreten Problem arbeitet. Ich bin beispielsweise in diversen Kundenprojekten bei EuroCC Austria involviert, durch die ich ebenfalls viel an Praxisnähe lerne.

Gibt es etwas, was dich verblüfft hat, als du begonnen hast, dich mit HPC zu beschäftigen?

Als ich angefangen habe, bei EuroCC zu arbeiten, und das erste Mal den Supercomputer gesehen habe, war ich ein bisschen underwhelmed, könnte man sagen. Je neuer die Maschine ist, umso kleiner ist sie. Ich habe mir eine riesige Halle mit hunderten von Racks vorgestellt, wo man kaum das andere Ende sieht. Ich glaube, der durchschnittliche Schrankraum in einer Hietzinger Villa ist größer als ein Supercomputer. Was mich dann weiter verblüfft hat, war, wie komplex die Kühlung dieser Geräte ist. Die nimmt dann nämlich wirklich viel Raum ein.

Was fasziniert dich persönlich an HPC?

Mich fasziniert in erster Linie die Tatsache, dass da gerade eine industrielle Revolution stattfindet. Es wird sich vermutlich in sehr kurzer Zeit sehr viel tun; wahrscheinlich mehr als in irgendeiner der industriellen Revolutionen davor. Ich finde es spannend und beflügelnd zu wissen, dass man Teil dieses Geschehens und da an vorderster Front mit dabei ist – selbst wenn man nur die Rolle eines verschwindend kleinen Rädchens spielt.

Was mich auch fasziniert, ist, dass man mit sehr vielen unterschiedlichen wissenschaftlichen Disziplinen in Kontakt kommt, sei es Materialwissenschaften oder der Engineering-Bereich oder auch Geisteswissenschaften. Mir gefällt, dass ich von allem ein bisschen was mitbekomme.

Zur Person

Simeon Harrison arbeitet seit 2021 im nationalen Kompetenzzentrum EuroCC Austria daran, Know-how rund um die Themen High-Performance Computing (HPC), Big Data und Künstliche Intelligenz (KI) in Österreich und Europa zu verbreiten. Wissen zu vermitteln war immer schon Simeons Leidenschaft: Bevor er sich mit Supercomputern beschäftigte, brachte er Matura-Schüler:innen alles rund um Polynome, Asymptoten und Integralfunktionen bei. Bei EuroCC hat er sich auf das heute boomende Feld Deep Learning/Machine Learning spezialisiert.

Trainings am Vienna Scientific Cluster (VSC)

Österreichs Supercomputer, der VSC, wurde 2009 erstmals in Betrieb genommen, 2015 wurden die ersten Trainings abgehalten, die auf Anhieb ausgebucht waren. Heute bietet der VSC jährlich rund 35 unterschiedliche Trainings an, vom VSC-Intro-Kurs, über MPI und C++ bis hin zu Python for HPC und Large Language Models.

Jährlich nehmen rund 1.200 Personen an den Trainings teil. Die Kurse sind kostenlos für alle VSC-User:innen und Mitarbeiter:innen österreichischer Universitäten bzw. für alle in Europa, solange der Kurs über EuroCC mitfinanziert wird. Nur für Kurse, die nicht in EuroCC fallen, zahlen Teilnehmer aus der Industrie und nicht-österreichische Teilnehmer eine kleine Kursgebühr.

Infos zu den Kursen gibt es hier: events.vsc.ac.at

Die wichtigsten Begriffe kurz erklärt

HPC ist die Abkürzung für High-Perfomance Computing, zu Deutsch Hochleistungsrechnen. Ob man es glaubt oder nicht, aber HPC ist eigentlich eine relativ alte Sache: Das Wort „Supercomputing“ wurde 1929 zum ersten Mal verwendet und die ersten Großrechner gab es in den 1950er-Jahren. Damals hatten sie allerdings sehr viel weniger Kapazität als ein heutiges Handy. So richtig Fahrt nahm die Technologie in den 1970er-Jahren auf.

HPC-Systeme kommen immer dann zum Einsatz, wenn der eigene Arbeitsspeicher zu klein ist, größere Simulationen gefragt sind, die auf dem eigenen System keinen Platz haben oder wenn das, was bisher lokal gerechnet wurde, künftig sehr viel öfter gerechnet werden soll.

Die Leistungsfähigkeit von Supercomputern wird in FLOPS (auch FLOP/s) gemessen (Floating Point Operations Per Second). 1997 erreichte ein Supercomputer erstmals 1,06 TeraFLOPS (1 TeraFLOPS = 1012 FLOPS), Österreichs aktuell leistungsstärkster Supercomputer, der VSC-5, bringt es auf 2,31 PetaFLOPS oder umgerechnet 2.310 TeraFLOPS (1 PetaFLOPSs = 1015 FLOPS). 2022 brach die Ära der Exascale-Computer an, deren Leistung in ExaFLOPS gemessen wird (1 ExaFLOPS = 1018 FLOPS). Ein ExaFLOPS entspricht einer Trillion (1018) Gleitkommaoperationen pro Sekunde.

Mit Stand Juni 2024 gab es in der TOP500-Liste der weltbesten Supercomputer nur zwei Exascale-System, nämlich Frontier am Oak Ridge National Laboratory und Aurora am Argonne National Laboratory, beide in den USA. In Europa gibt es derzeit drei Pre-Exascale-Rechner, also Vorstufen der Exascale-Systeme. Zwei europäische Exascale-Systeme werden in naher Zukunft in Betrieb gehen.

Der VSC (Vienna Scientific Cluster)ist der Supercomputer Österreichs, gemeinsam finanziert von mehreren österreichischen Universitäten. Die Rechner befinden sich in Wien an der TU Wien. Ab 2025 ist der neueste Supercomputer MUSICA (Multi-Site Computer Austria) an den Standorten Wien, Linz und Innsbruck im Einsatz. Forscher:innen der beteiligten Unis können den VSC für ihre Simulationen nutzen und im Rahmen von EuroCC haben auch Unternehmen einfachen Zugriff auf Rechenzeit auf Österreichs Supercomputer. Zudem ist das Team des VSC eine wichtige Quelle von Know-how: In zahlreichen Workshops lernen künftige HPC-User:innen, egal welcher Niveaus, alles über Supercomputing, KI und Big Data.

Das EuroHPC Joint Undertaking ist eine öffentlich-private Partnerschaft der Europäischen Union, um eine europaweite Hochleistungsrechnerinfrastruktur aufzubauen und international wettbewerbsfähig zu halten. EuroCC ist eine Initiative von EuroHPC.

Jedes der teilnehmenden Länder (EU plus einige assoziierte Staaten) hat ein nationales Kompetenzzentrum für Supercomputing, Big Data und Künstliche Intelligenz aufgebaut, die nationalen EuroCCs (z. B. EuroCC Austria). Sie sind Teil des gleichnamigen EU-Projekts, das künftigen User:innen die Technologie näherbringt und den Zugang zu Supercomputern erleichtert. Der Fokus liegt auf kleinen und mittleren Unternehmen und Start-ups, die unter anderem mit Trainings und Support unterstützt werden, HPC zu nutzen. Das Joint Undertaking fördert auch das EUMaster4HPC-Projekt, ein Ausbildungsprogramm für angehende HPC-Expert:innen.